티스토리 뷰

Artificial Intelligence/Dynamic Bayesian Network

Hidden Markov Model 구조와 확률

Unikys 2007. 9. 16. 20:46Architecture of a hidden Markov model

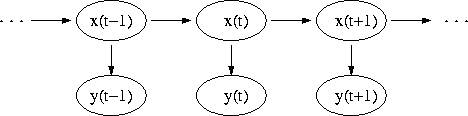

- 그림이 일반적인 HMM의 구조이다. 각 타원형은 일정 수의 랜덤 값들을 받을 수 있는 변수들을 나타낸다. x(t)는 시간 t에 hidden 변수들이 가지고 있는 값들이다. y(t)는 시간 t에 관측 가능한 변수들이다. 화살표는 의존성을 나타낸다. 그림에서 hidden 변수 x(t)는 다른 hidden 변수인 x(t-1)으로 부터만 영향을 받는 것을 볼 수 있다.(Markov property라고 한다) 똑같이 y(t)는 x(t)의 값에 대해서 영향을 받는다.

Probability of an observed sequence

- Y = y(0), y(1), ... , y(L-1) 의 관측 순서, L은 관측 길이에서 확률은 아래와 같다.

sum은 X = x(0), x(1), ... , x(L-1)을 적용시킨 것이다. P(Y)는 매트릭스 곱셈으로 처리할 수 있다. (실제 값들을 처리하는데 있어서 계산 시간과 용량이 필요로 하는데 이에 대한 여러 처리 알고리즘들이 있다, forward-backward algorithm, Viterbi algorithm..)

/* 뭐 내용은 좀 뻔한 내용..베이스 규칙에 의해서 관측된 P(Y)로 P(X)를 구하는 것이 아마 이 HMM의 활용일 것이다.*/

공지사항

최근에 올라온 글

최근에 달린 댓글

- Total

- Today

- Yesterday

TAG

- 탐론 17-50

- GX-10

- ny-school

- 삼식이

- 뽐뿌

- HTML5

- 안드로이드 앱 개발 기초

- TIP

- HTML5 튜토리얼

- php

- 사진

- 팁

- c++

- 강좌

- 속깊은 자바스크립트 강좌

- Android

- 자바스크립트

- Javascript

- java

- google app engine

- gae

- Python

- mini project

- Writing

- 안드로이드

- 샷

- lecture

- 서울

- gre

- K100D

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |

글 보관함